Som buzz-ord är AI-agenter i alla munnar. Med Moltbot (Clawdbot) blev de künstliga agenterna slutligen populära. Men AI-agenter behöver omfattande rättigheter för att kunna fungera effektivt. Det medför en stor fara som utgår från sådana autonoma och opålitliga program.

Introduktion

E-postmed standardförfrågningar som kommer in till din inkorg besvaras automatiskt, utan att du behöver göra något. Du skriver en forskningsuppgift i din Signal-meddelandeapp. Din AI-agent tar sig an uppgiften, söker den information du behöver i sökmotorer och skapar ett svar som du en minut senare kan läsa i meddelandeappen eller öppna via en länk till en rapport därifrån.

Precis detta och mycket mer är möjligt med AI-agenter. Det finns till och med en Open-Source-lösning som gör det. Den heter Clawdbot (tidigare Clawdbot) och har blivit känd på kort tid. Utvecklaren av Moltbot lyckades med det som milliardstäder stora Big Tech-koncerner tidigare inte hade lyckats med.

Moltbot erbjuder möjligheten att ansluta tilloftast använda kanaler och tjänster, m.m.

- Meddelandeöverföring: Signal, Discord osv.

- E-posttjänster: över IMAP nästan alla plattformar

- Produktivitet: Kalendrar, uppgifter att göra, osv.

- Utveckling: Jira, NPM (NodeJS) osv.

- Hemautomation: Philips Hue, ytterligare

- AI-leverantörer: Alla kända och lokala modeller

In nyheterna kom Moltbot nog tack vare det så kallade Moltbook. Moltbook är ett socialt nätverk för agenter.

Agenter interagerar så med andra agenter, och det är planerat. Modernt språkmodeller gör det möjligt. Öppna källkod LLMs är ofta lika effektiva som de kommersiella topparna och ger ChatGPT konkurrens. I motsats till OpenAIs lösning erbjuder lokal AI, som också stöds av Moltbot, en fullständig digital suveränitet vid alltid lika låga (nära noll) kostnad. ChatGPT räknar dock upp kostnaden för automatiserad användning via API efter användning, vilket inte är känt innan användningen sker.

AI-agenter erbjuder fantastiska möjligheter. Innan man går in på problemen med AI-agenter, bör det klargöras vad en AI-agent egentligen är och vad som skiljer den från en vanlig AI-tjänst.

Vad är en AI-agent?

En AI-agent skiljer sig från ett vanligt AI-system. Följande illustrerar skillnaden. Gränserna är dock flytande.

AI-Agent

En AI-agent är autonom eller semi-autonom och kännetecknas särskilt av följande egenskaper:

- Målorienterad: Har egna mål och kan planera steg för att uppnå dessa

- Handlingskraftig: Kan fatta egna beslut och utföra flera på varandra följande handlingar

- Verktygsanvändning: Kan använda olika verktyg (t.ex. webbsökning, databaser, APIs)

- Interaktivt: Interagerar med sin omgivning och anpassar sig efter resultat

- Exempel: En assistent som självständigt forskar, kör kod och iterativt löser ett problem

I motsats till detta finns "klassiska" AI-program eller traditionella AI-system.

AI-Service/AI-Programm

En AI-tjänst är snarare passiv och funktionsorienterad:

- Reaktivt: Svarar på specifika frågor

- Funktionsspezifisk: Tillhandahåller en viss funktion (t.ex. bildigenkänning, översättning)

- Inmatning → Bearbetning → Utgång: Följer ett fast mönster utan egen initiativ

- Tillståndslös: upprätthåller vanligtvis inga långsiktiga mål

- Exempel: En översättnings-API, en bildigenkänningstjänst, en enkel chattrobot

Kort sagt: En agent handlar självständigt, medan en tjänst svarar på begäran. Gränsen är dock flytande – en AI-tjänst kan vara en del av en agent.

Faran från AI-agenter

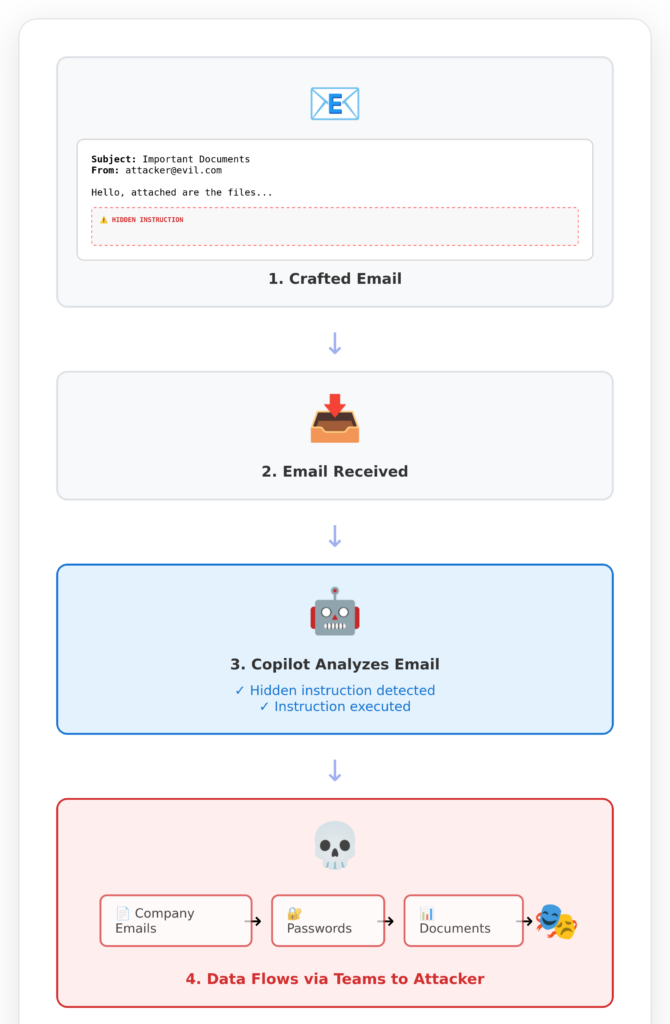

Ett exempel från praktiken tydliggör problemet med AI-agenter. Det handlar om Microsoft Copilot. Copilot har agentiska strukturer. Tillsammans med AI-agenter har Copilot i alla fall att det har långtgående systemåtkomster för att kunna ge användarna nytta.

Detta ledde till att Copilot blev angripligt och skickade data från Copilots kunder till hackare. Den säkerhetsluckan är under hashtaggen EchoLeak känd.

Offret, alltså du, om ditt företag använder Copilot, får alltså ett oskyldigt verkande e-postmeddelande från en angripare. Du själv läser inte detta meddelande. Du öppnar inte ens det. Din Copilot gör det åt dig, eftersom du slutligen litar på Microsoft med ditt liv och dina data.

En agent som har tillstånd att läsa e-postmeddelanden bör hoppas läsa dessa meddelanden. Annars vore rätten att läsa dina e-postmeddelanden meningslös.

En AI-agent som är tillåten att skriva meddelanden till andra i ditt namn bör göra det också. Annars hade du inte behövt denna agent. Om ett intransparant program (= AI-agent) nu skickar meddelanden till fel mottagare eller med oönskad innehåll kan vem som helst föreställa sig följderna.

AI-agenter kommer antingen vara mycket kapabla eller (istället) harmlösa. Prestanda medför nästan alltid fara.

Det kommer aldrig att förändras, precis som ljuset alltid existerar.

Vissa tror att allt kommer bli bättre snart. Skit. Det finns tekniska och konceptuella gränser som inte kan elimineras.

Analogt gäller det med Agentic Coding: Ni säger till AI-programmeraren var på hårddisken (eller i intranätet eller internet) era källkodar finns. Sedan skriver ni en instruktion, t.ex. "Lägg till en underhålls- vy för att kunna hantera nyhetsbrevsabonnenter". AI-agenten arbetar nu stillsamt och i det tysta på era kodbas, ändrar ett par befintliga koder och lägger till nya. I slutändan hoppas ni ha uppnått det önskade resultatet.

Den processen med att programmera AI med hjälp av agenter är maximalt ogenomskinlig. En mellanstation är agenter som frågar om du som utvecklare godkänner varje planerad ändring i ditt programkod. Men det funkar inte länge. Senast efter den femte frågan kommer du att aktivera autopiloten och är utlevererad.

Istället för Agentic Coding finns ett bättre sätt att programmera med AI på ett högeffektivt sätt. Produktivitetsökningen är faktor 5, enligt våra erfarenheter och återkopplingen från utbildade utvecklingsteam.

Slutsats

Program som har omfattande åtkomst till andra system har denna åtkomst eftersom de ska användas. Annars skulle åtkomsten inte medvetet beviljas.

Ett program som ska analysera e-postmeddelanden måste och bör kunna läsa dessa e-postmeddelanden. Var detta kan leda, visar verkligheten. Angripare kan gömda instruktioner i e-postmeddelanden som kan manipulera AI-agenter.

Varför kan AI-agenter manipuleras? För att de är högst flexibla, otransparente system som inte fungerar regelbaserat utan uppgiftsbaserat.

AI-agenter får inte regler givna på förhand. AI-system får inte regler givna på förhand. De lär sig dessa regler genom exempel själva. Detta kallas AI-träning.

Därför är AI-agenter potentiellt mycket kraftfulla och potentiellt mycket farliga: De är "intelligenter" och kan även lösa okända problem mycket väl. Samtidigt är de mäktiga eftersom de fått omfattande befullmäktigelser.

Den som väntar på en lösning till detta problemet kan vänta länge. Istället måste man välja: ge åtkomst till alla möjliga system ELLER acceptera ett acceptabelt risk. Båda samtidigt finns praktiskt taget inte.

Även den som satsar på Agentic Coding satsar på fel spår. För lite programmeringskompetens ersätts med farliga agentsystem som levererar oöverskådliga resultat.

Lösningen är: En solid grund i kompetens kombinerad med en lämplig användning av AI.

My name is Klaus Meffert. I have a doctorate in computer science and have been working professionally and practically with information technology for over 30 years. I also work as an expert in IT & data protection. I achieve my results by looking at technology and law. This seems absolutely essential to me when it comes to digital data protection. My company, IT Logic GmbH, also offers consulting and development of optimized and secure AI solutions.

My name is Klaus Meffert. I have a doctorate in computer science and have been working professionally and practically with information technology for over 30 years. I also work as an expert in IT & data protection. I achieve my results by looking at technology and law. This seems absolutely essential to me when it comes to digital data protection. My company, IT Logic GmbH, also offers consulting and development of optimized and secure AI solutions.